学术界缺乏AI研究所需的强大算力?

2025-07-07 中国教育和科研计算机网

大型科技公司也许拥有数千块GPU,但学术界可能只有几块。要让学术界成为AI创新生态系统的强大支柱,提升学术界所能支配的计算资源是第一步。

《Nature》杂志报道,一项针对全球数十家机构的学者进行的调查显示,许多大学的科学家都对用于人工智能研究的算力资源之有限感到沮丧。

一项发布在arXiv上的研究报告显示,学术界缺乏使用最先进计算系统的机会,这可能会阻碍他们开发大语言模型和进行其他人工智能研究。

尤其是,学术研究人员难以获得足够强大的GPU,用于训练人工智能模型的计算机芯片通常需要数千美元。相比之下,大型科技公司的研究人员可支配的预算更高,可以在GPU上花更多的钱。研究报告的合著者、布朗大学计算机科学家阿普尔夫·坎德尔瓦尔(Apoorv Khandelwal)表示,每增加一块GPU都会增加更多算力。大型科技公司也许拥有数千块GPU,但学术界可能只有几块。

算力不足影响创新

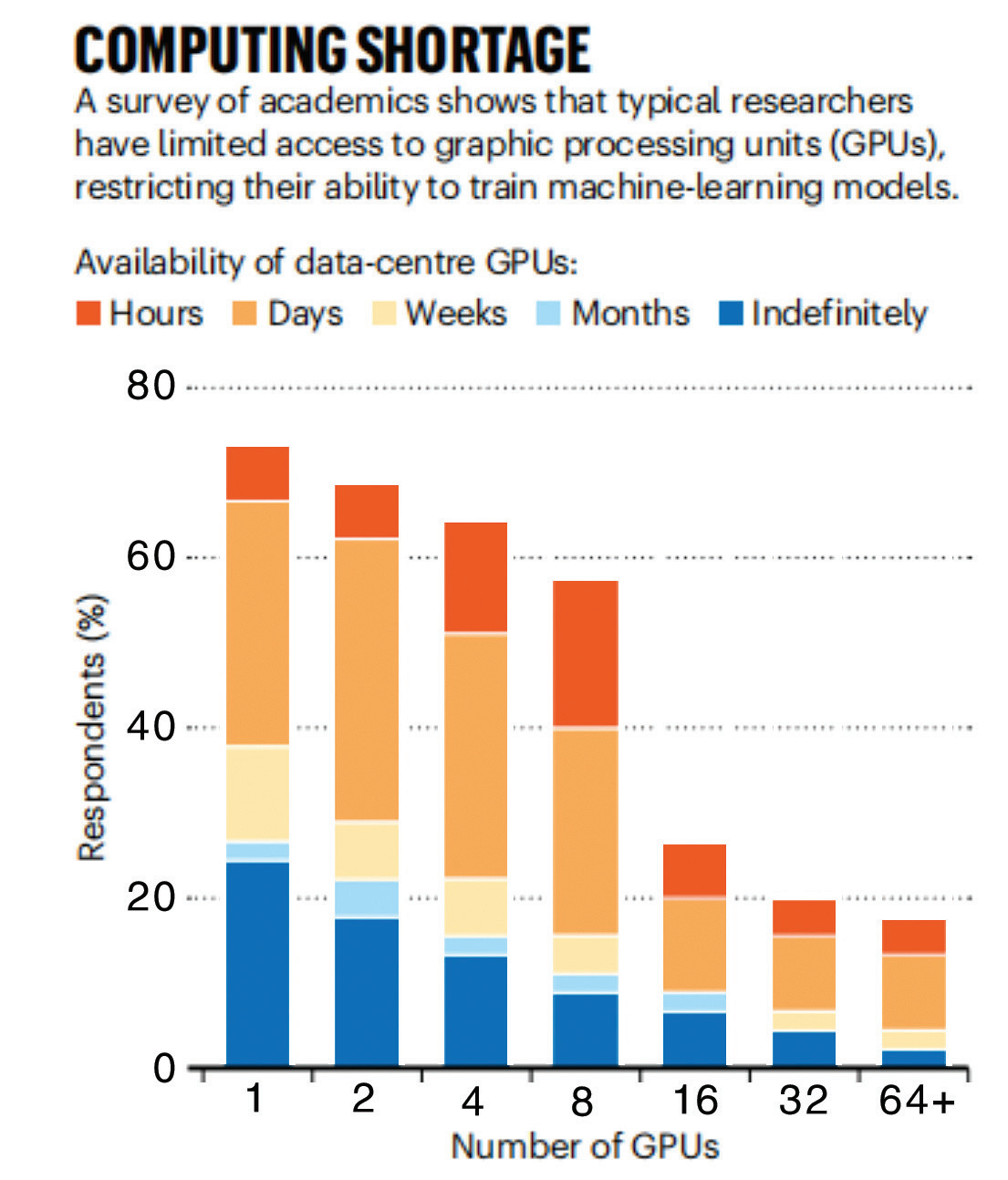

为了评估学术界可使用的计算资源,坎德尔瓦尔和同事们对35个机构的50名科学家进行了调查。在受访者中,66%的人对算力的满意度为3分或以下(满分为5分)。“他们根本不满意。”坎德尔瓦尔说。

各大学对于GPU的使用规则各不相同。有些大学有一个中央计算集群,由院系和学生共享,研究人员可以申请GPU使用时间。其他的大学可能会购买机器供实验室成员直接使用。

一些科学家表示,他们需要等待数天才能使用GPU,并指出,在项目截止日期前后等待的时间尤其长。研究结果还凸显了全球算力方面的差距。例如,一位受访者表示,在中东很难找到GPU。只有10%的受访者表示,他们可以使用英伟达(NVIDIA)的H100GPU,这种芯片专为人工智能研究设计。

△研究机构可使用的GPU数量和可用时长

算力的短缺使得人工智能预训练——将大量数据输入大语言模型——尤其具有挑战性。“太贵了, 大多数学者根本不考虑靠预训练来搞科研”。坎德尔瓦尔表示。他与同事们都认为,学者们为人工智能的研究提供了独特视角,缺乏算力可能会限制学界在人工智能领域的发展。

“对于长期的增长和技术发展而言,拥有健康、有竞争力的学术研究环境非常重要。”研究报告的合著者爱丽·帕弗利克(Ellie Pavlick)表示,“当进行产业研究时,就会面临明显的商业压力,这会使得人们想要更快地开发,更少地探索。”

如何有效利用计算资源

研究人员还调查了学术界如何更好地利用功率较低的计算资源。他们计算了使用较低计算资源的硬件(1~8块GPU)训练多个大语言模型所需的时间。尽管资源有限,研究人员还是成功地训练了许多大模型,尽管所花费的时间更长,且需要采用更高效的方法。

“实际上,我们可以尽可能将现有的GPU使用更长时间,如此一来,学术界可弥补与工业界之间算力的差距。”

“在有限的计算资源条件下,你可以训练出比很多人想象中规模更大的模型,这很酷。”德国萨尔兰大学研究神经显著性模型的李吉云(Ji-Ung Lee)表示,“未来,我们将研究小型科技公司的现状,他们也很难获得计算资源,并不是每个人都能无限制地获得无穷算力。”

为学术界提供GPU

2024年,美国《麻省理工科技评论》(MIT Technology Review)刊登了一篇题为《美国可以通过3种方式帮助大学在AI创新方面与科技公司竞争》的文章。文章指出,ChatGPT、Claude和Gemini这样的大型基础模型(LFM)需要强大的算力和广泛的数据集,以至于科技公司已经取代了原本处于AI前沿的学术界。2023年10月,拜登政府发布一项人工智能行政命令,授权国家人工智能资源研究(NAIRR)试点。通过与科技公司合作,NAIRR将创建一个共享的研究基础设施,帮助学术研究人员更有效地获得GPU算力。此外,还应寻求更多创造性的解决方案,将数量可观的GPU交到学术界手中。

使大学与科技公司并肩站在AI研究的前沿,将是实现AI领域突破的关键,这就需要进一步缩小学术界和工业界在获取计算资源方面的显著差异。对此,文章提出了三种方法。首先,使用大规模GPU集群来改进和利用美国政府已经资助的超级计算机基础设施。其次,美国政府应探索降低学术机构高端GPU成本的方法。最后,美国政府可以购买因出口管制限制导致积压的尖端AI芯片库存,将其分配给全美的大学和研究机构。

来源:Nature,MIT Technology Review

编译:陈茜

特别声明:本站注明稿件来源为其他媒体的文/图等稿件均为转载稿,本站转载出于非商业性的教育和科研之目的,并不意味着赞同其观点或证实其内容的真实性。如转载稿涉及版权等问题,请作者在两周内速来电或来函联系。

相关阅读

从1万多条问答中思考:高校师生需要怎样的AI助手?2025/06/12

人民日报海外版:如何引导中小学生用好AI帮手?2025/05/30

高校领导应该询问的七个AI关键问题2025/06/04

AI让高等教育变革的理想照进现实2025/04/17

案例分享|高校AI教育应用新生态2025/04/10

将AI融入高等教育的挑战与解决思路2025/03/27

锁志海:坚守育人初心 让AI赋能高校创新发展2025/03/19

案例分享丨AI如何赋能高校数字化转型2024/12/13

人民日报海外版:如何引导中小学生用好AI帮手?2025/05/30

高校领导应该询问的七个AI关键问题2025/06/04

AI让高等教育变革的理想照进现实2025/04/17

案例分享|高校AI教育应用新生态2025/04/10

将AI融入高等教育的挑战与解决思路2025/03/27

锁志海:坚守育人初心 让AI赋能高校创新发展2025/03/19

案例分享丨AI如何赋能高校数字化转型2024/12/13

一起关注互联网发展、互联网技术、互联网体系结构……

在教育部科技司领导下,中央电化教育馆组织实施了教育信息化教学应用实践共同体项目...

工作要点聚焦:教育信息化、网络安全……都怎么干?

京公网安备 11040202430174号

京公网安备 11040202430174号